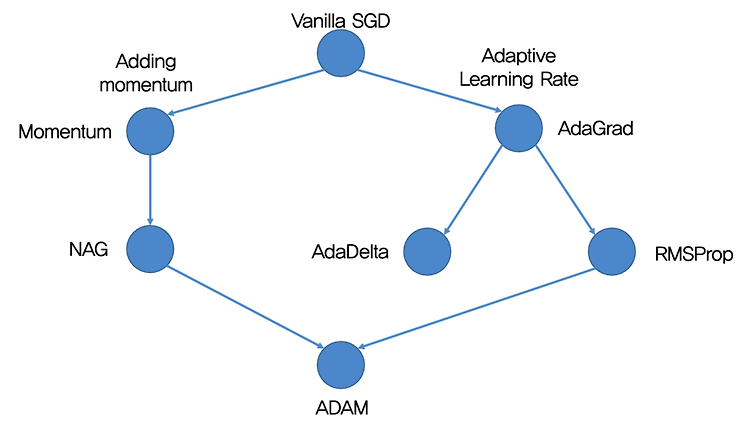

기본적인 옵티마이저들에 대해서 정리해 놓자. 아래와 같은 흐름으로 옵티마이저의 발전 흐름을 정리할 수 있다. SGD SGD는 미니배치에 대해 그래디언트를 구함으로써 학습이 빠르다는 장점이 있다. 배치를 다 보면 아무래도 메모리가 부족하고, 계산에 시간이 오래 걸리니... 그렇다고해서 수렴이 빠르다고 할 수는 없다. SGD의 문제점 로컬 미니마를 벗어나기 힘들고 갖힐 경우 수렴이 느림 스텝사이즈가 모든 파라미터에 대해 똑같음 (상수 러닝레잇을 곱해줌) 어떤 weight은 많이 업데이트 되었고, 어떤 weight에 대해선 그렇지 않다면 각 weight 별로 스텝이 달라져야하지 않을까? 크게 두 가지 문제점을 해결하는 방향으로 옵티마이저가 발전해왔다. Momentum 기울기의 움직임에 대해 관성을 부여해서 로..